Il Rilevamento CSAM di Apple Servirà Savvero per il Suo Scopo Originale?

Apple ha introdotto una nuova serie di misure tecnologiche per prevenire gli abusi sui minori (CSAM, Child Sexual Abuse Material). Il “machine learning” verrà utilizzato nelle attivazioni degli account iCloud della famiglia per rilevare eventuali nudità nelle immagini. Il sistema bloccherà la ricezione o l'invio di tali scatti, visualizzerà avvisi e avviserà i genitori che il bambino li ha inviati o visualizzati.

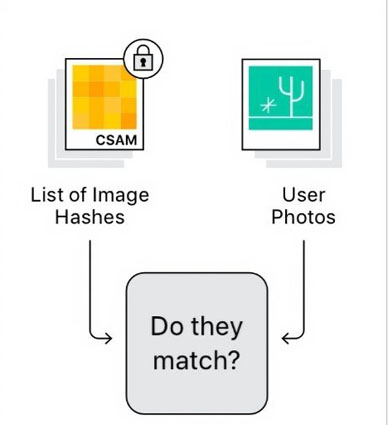

Apple ha chiarito che nessuna di queste funzionalità mette in pericolo la privacy dell'utente. Verrà utilizzata una crittografia intelligente per il meccanismo di rilevamento di iCloud per impedire al meccanismo di scansione di accedere a qualsiasi immagine che non sia CSAM. Apple è sicura che il nuovo sistema svolgerà un ruolo significativo nel contrasto dello sfruttamento minorile.

- Parte 1: cos'è il rilevamento CSAM di Apple?

- Parte 2: Perché il CSAM di Apple sembra controverso?

- Parte 3: posso interrompere il rilevamento CSAM?

- Parte 4: Qual è l'ultima risposta di Apple alla controversia CSAM?

Parte 1: cos'è il rilevamento CSAM di Apple?

Apple ha annunciato tre aggiornamenti separati riguardo la sicurezza dei bambini. CSAM è il più significativo di questi aggiornamenti, ha attirato molta attenzione per essere in grado di effettuare una scansione delle foto custodite su iCloud. Questa funzione può confrontare le immagini degli utenti con un database del materiale identificato in precedenza. Quando viene rilevata una serie di immagini specifiche, viene attivato un processo di revisione “umana”.

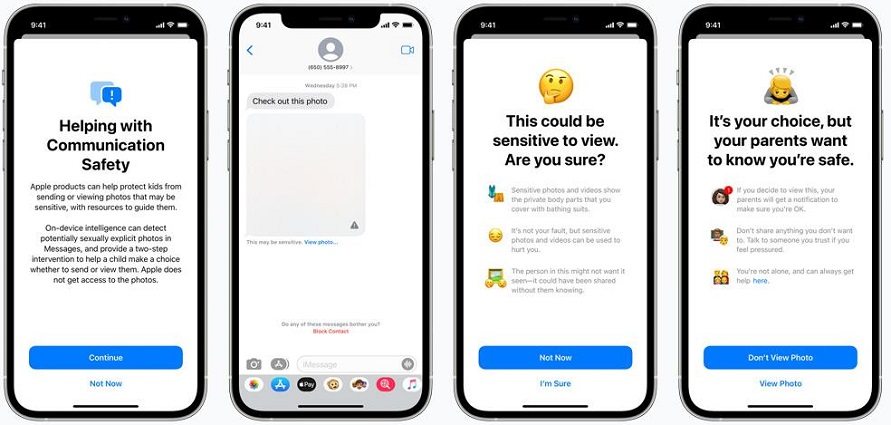

Se le immagini verranno verificate con esito positivo, Apple sospenderà l'account iCloud e questo verrà automaticamente segnalato all'NCMEC o al National Center for Missing and Exploited Children. Esistono anche funzioni di sicurezza per l'app dei messaggi che consentiranno di rilevare quando vengono inviate o ricevute foto sessualmente esplicite da parte di bambini.

All’eventuale ricezione di un’immagine esplicita per i bambini di età superiore ai 13 anni l’app Messaggi emetterà un avviso. Oltre a ciò, Apple sta aggiornando le sue capacità di ricerca e Siri per intervenire riguardo le domande riguardanti CSAM. Siri sarà in grado di fornire collegamenti per segnalare il materiale di abuso.

Parte 2: Perché il CSAM di Apple sembra controverso?

Sebbene molte persone siano per lo più d'accordo sul fatto che questo particolare sistema sia adeguatamente limitato, un certo numero di watchdog, esperti e sostenitori della privacy sono sostanzialmente preoccupati per la possibilità di abusi che un sistema del genere può generare. Numerosi provider di cloud storage come Microsoft e Dropbox stanno già eseguendo il rilevamento delle immagini sui propri server. Pertanto, molte persone sono in disaccordo e pensano di passare a telefoni con sistemi Android. Inoltre, ci sono varie controversie sull'Apple CSAM; quindi, diverse persone hanno dato pareri contrastanti.

1. Chi è d’accordo

- Benny Pinkas è un crittografo presso la Bar Ilan University di Israele e ritiene che il sistema PSI di Apple offra un eccellente equilibrio tra utilità e privacy. Per lui, può essere costruttivo identificare qualsiasi contenuto CSAM mantenendo la privacy dell'utente e il minimo di falsi positivi.

- Julie Cordia è l'amministratore delegato di un gruppo di difesa della sicurezza dei bambini chiamato Thorn e crede che questa mossa di Apple aiuti ad avvicinare le persone alla giustizia, specialmente per quei sopravvissuti i cui momenti traumatici sono stati diffusi online.

- Crittografi e scienziati informatici come David Forsyth, Dan Boneh e Mihir Bellare ritengono che questo sistema possa aumentare significativamente la probabilità di scovare immagini esplicite di abusi su minori e sono pronte a sacrificare una piccola perdita di privacy.

2. Chi non è d’accordo

- Nadim Koeissi è un crittografo e fondatore di un'azienda nota come Symbolic Software. Per Koessi, l'idea che il tuo dispositivo personale ti scansioni e ti controlli in base ad alcuni criteri di contenuto discutibili e poi lo segnali alle autorità può essere un pendio piuttosto scivoloso. Kendra Albert è un'istruttrice della Harvard Cyberlaw Clinic che ha espresso le sue preoccupazioni in merito alle notifiche ed alla possibilità di intrusione dei genitori nella vita dei figli.

- Kendra Albert is a Harvard Cyberlaw Clinic instructor who has raised her concerns regarding the notifications. She believes that this could end up having queer or transgender kids, as their parents will be encouraged to snoop on them.

- Un professore dell'Osservatorio Internet di Stanford di nome Alex Stamos mette in dubbio la capacità di Apple di operare con la comunità di specialisti della crittografia. Pensa che Apple sia entrata nel dibattito e abbia calcato la mano senza una discussione o una consultazione pubblica.

3. Altre controversie sul CSAM di Apple

Due accademici della Princeton Univeristy affermano di considerare sicuramente il CSAM di Apple vulnerabile poiché ne hanno già sviluppato uno simile. Secondo loro, il sistema funzionava allo stesso modo, ma avevano subito individuato un problema evidente.

- Il Washington Post ha pubblicato un editoriale in cui questi ricercatori affermano di aver passato due anni a sviluppare un CSAM simile ad Apple. La storia ha preso una svolta piuttosto drammatica dopo l'ammissione di Apple di aver eseguito CSAM negli ultimi tre anni. Pertanto, lo considerano un severo avvertimento per milioni di utenti Apple iPhone.

Parte 3: posso interrompere il rilevamento CSAM?

Ci sono molti utenti di iPhone e iPad preoccupati per la funzione di rilevamento che potrebbe essere implementata quando si verificherà il prossimo importante aggiornamento di iOS e iPadOS. C'è ancora un'opzione disponibile per impedire ad Apple di scansionare le foto personali di chiunque. Vale la pena notare che lo strumento CSAM esamina solo le immagini caricate su iCloud. Per fare chiarezza, nessuna foto che l'utente invierà tramite app crittografate end-to-end come Whatsapp o Telegram verrà scansionata.

Se hai già sincronizzato le foto su iCloud e desideri impedire allo strumento di rilevamento di scansionare le foto, devi eseguire i seguenti passaggi:

- Puoi iniziare andando su impostazioni, quindi alla sezione Foto.

- Dovrai attivare/disattivare le foto di iCloud per disabilitare la sincronizzazione.

Per ottenere i file multimediali dalla libreria iCloud, ti verrà richiesto di fare clic su "Scarica foto e video".

Parte 4: Qual è l'ultima risposta di Apple alla controversia CSAM?

C'è stata una forte smentita da parte di Apple per quanto riguarda la riduzione della privacy. Un documento dettagliato in cui affronta la maggior parte dei reclami è stato pubblicato dalla società. Apple sottolinea ancora che confronta solo le foto degli utenti con qualsiasi raccolta di materiale di sfruttamento minorile noto. Pertanto, una segnalazione non verrà attivata se sono presenti semplici foto dei propri figli, ad esempio.

Apple ha anche affermato che le probabilità di un falso positivo sono una su un trilione considerando anche il fatto che è necessario rilevare un certo numero di immagini per attivare una segnalazione. Tuttavia, Apple non ha fornito molte informazioni ai ricercatori esterni sul funzionamento dei sui algoritmi, sostanzialmente dobbiamo crederci sulla parola.

Inoltre, Apple afferma che la revisione manuale si basa su revisori umani ed è in grado di rilevare se materiale CSAM si trova su un dispositivo a causa di un attacco esterno. L'azienda si rifiuterà di collaborare con i governi e le forze dell'ordine perché, in passato molte istituzioni hanno chiesto di apportare modifiche per ridurre la privacy degli utenti.

Conclusione

Negli ultimi giorni, Apple ha continuato a fare chiarezza sulla funzione di rilevamento CSAM. È stato chiaramente affermato che CSAM si applica solo alle foto archiviate in iCloud e non ai video. La società difende anche l’uso di questo algoritmo di rilevamento come rispettoso della privacy, ben di più rispetto ad alter società che lo utilizzano. Tuttavia, l'azienda ha anche riconosciuto che si può fare molto di più in futuro e che i piani possono essere ampliati ed evoluti nel tempo. Ulteriori spiegazioni su CSAM arriveranno più avanti, quindi attendiamo che venga fatta ulteriore chiarezza.

Apprezziamo la tua opinione sugli ultimi sviluppi relativi a CSAM, pertanto, vorremmo che tu fornissi i tuoi commenti di seguito sugli aggiornamenti per la sicurezza dei bambini che Apple sta implementando.